Nightshade: a ferramenta que envenena geradores de arte de IA como o Dall-E

Uma nova ferramenta chamada Nightshade pode envenenar geradores de arte de IA como o Dall-E, alimentando-os com imagens adulteradas que podem produzir resultados imprevisíveis e indesejáveis.

A Nightshade funciona explorando uma vulnerabilidade de segurança nos modelos de IA generativos, que são treinados em grandes quantidades de dados, incluindo imagens coletadas da internet. Ao adulterar essas imagens, a ferramenta pode confundir e enganar os modelos de IA.

Ben Zhao, professor de ciência da computação na Universidade de Chicago e crítico das práticas de raspagem de dados de IA, mencionou ao MIT Technology Review sobre a eficácia da Nightshade em envenenar qualquer modelo que use imagens para treinar IA.

Revolução Silenciosa dos Artistas

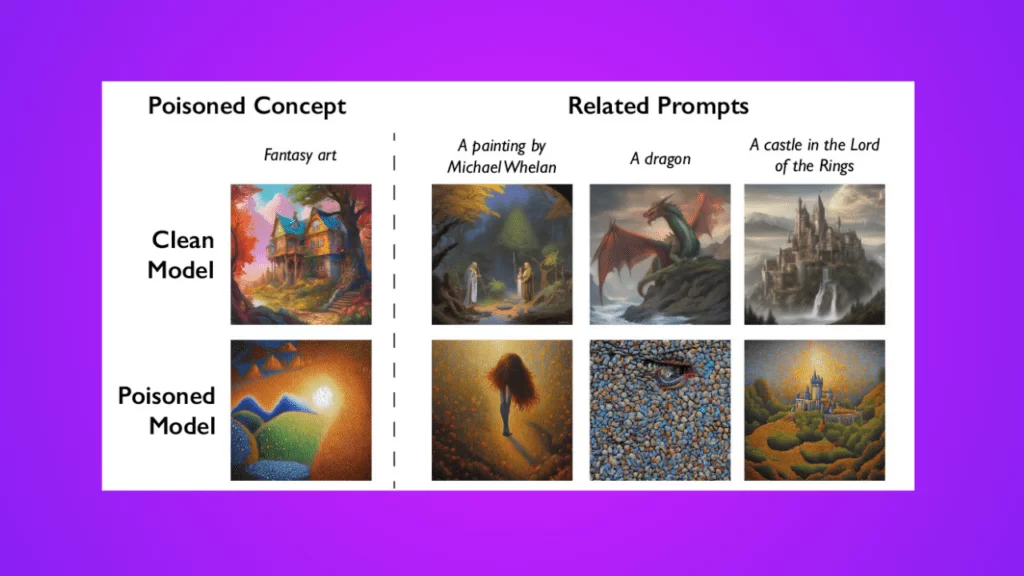

A equipe por trás da Nightshade sugere que a ferramenta pode ser usada para proteger artistas de furto de propriedade intelectual. Por exemplo, ao pedir ao SDXL para criar uma pintura no estilo do renomado artista de ficção científica e fantasia Michael Whelan, o modelo envenenado produz algo muito diferente do trabalho de Whelan.

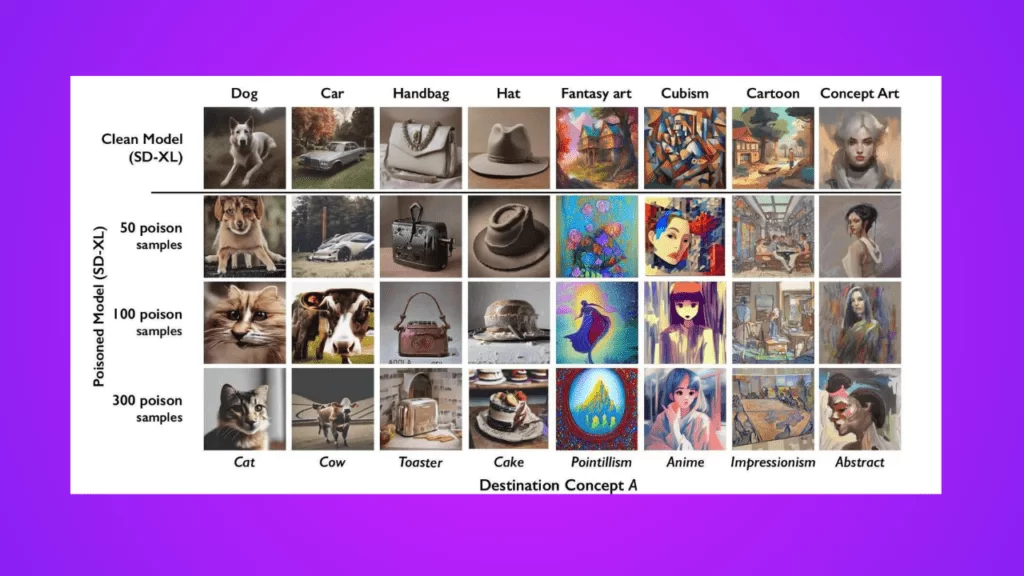

Ao “envenenar” esses dados de treinamento, a Nightshade pode danificar futuras iterações de modelos de IA geradores de imagens, como DALL-E, Midjourney e Stable Diffusion, tornando algumas de suas saídas inúteis – cães se transformam em gatos, carros se transformam em vacas, e assim por diante.

No entanto, alguns críticos alertam que a Nightshade pode ser usada para criar desinformação e propaganda enganosa, pois pode ser usada para gerar imagens falsas que parecem reais. Os críticos também dizem que a Nightshade pode ser usada para criar conteúdo ofensivo e nocivo, como imagens violentas ou pornográficas.

Empresas de IA, como OpenAI, Meta, Google e Stability AI, estão enfrentando uma série de processos de artistas que alegam que seu material protegido por direitos autorais e informações pessoais foram raspados sem consentimento ou compensação.

Ben Zhao, que liderou a equipe que criou o Nightshade, espera que a ferramenta ajude a equilibrar o poder das empresas de IA em favor dos artistas.

A equipe de Zhao também desenvolveu o Glaze, uma ferramenta que permite aos artistas “mascarar” seu próprio estilo pessoal para evitar que seja raspado por empresas de IA. A intenção é integrar o Nightshade ao Glaze, dando aos artistas a opção de usar a ferramenta de envenenamento de dados ou não. Quanto mais pessoas usarem e criarem suas próprias versões, mais poderosa a ferramenta se torna.

Ataque Direcionado e Implicações Futuras

O Nightshade explora uma vulnerabilidade de segurança em modelos de IA generativos. Estes modelos são treinados em vastas quantidades de dados, muitas vezes imagens que foram sugadas da internet. A Nightshade interfere nessas imagens.

Artistas que desejam carregar seu trabalho online, mas não querem que suas imagens sejam raspadas por empresas de IA, podem carregá-las no Glaze e optar por mascará-las com um estilo artístico diferente do deles. Uma vez que os desenvolvedores de IA raspam a internet para obter mais dados, essas amostras envenenadas entram no conjunto de dados do modelo e causam mau funcionamento.

Zhao admite que há um risco de que as pessoas possam abusar da técnica de envenenamento de dados para fins maliciosos. No entanto, ele diz que os atacantes precisariam de milhares de amostras envenenadas para causar danos reais em modelos maiores e mais poderosos.

Gautam Kamath, professor assistente da Universidade de Waterloo, diz que o trabalho é “fantástico”. A pesquisa mostra que as vulnerabilidades “não desaparecem magicamente para esses novos modelos, e de fato só se tornam mais sérias”.

Como a Nightshade pode ser usada para proteger artistas?

Os artistas podem usar a Nightshade para proteger seus estilos e técnicas de serem copiados por geradores de IA. Ao adulterar suas imagens com a Nightshade, os artistas podem tornar mais difícil para os geradores de IA aprenderem seus estilos e técnicas.

Por exemplo, um artista pode adulterar suas imagens de pinturas com a Nightshade, o que pode tornar mais difícil para os geradores de IA aprenderem a pintar como ele. Um artista também pode adulterar suas imagens de fotografias com a Nightshade, o que pode tornar mais difícil para os geradores de IA aprenderem a tirar fotos como ele.

Como a Nightshade pode ser usada para criar novos tipos de arte digital?

A Nightshade pode ser usada para criar novos tipos de arte digital, explorando as maneiras pelas quais os modelos de IA podem ser enganados e manipulados.

Por exemplo, um artista pode usar a Nightshade para criar imagens de sonhos ou pesadelos, alimentando os modelos de IA com imagens adulteradas que são projetadas para confundir e enganar.

Um artista também pode usar a Nightshade para criar imagens surrealistas ou oníricas, alimentando os modelos de IA com imagens adulteradas que combinam elementos de diferentes mundos e realidades.

Quais são os riscos da Nightshade?

A Nightshade é uma ferramenta poderosa que pode ser usada para criar desinformação e propaganda enganosa, pois pode ser usada para gerar imagens falsas que parecem reais. Por exemplo, um criminoso pode usar a Nightshade para gerar imagens falsas de um político dizendo ou fazendo algo que ele nunca disse ou fez. Essas imagens falsas podem ser usadas para manipular as eleições ou para prejudicar a reputação de uma pessoa.

A Nightshade também pode ser usada para criar conteúdo ofensivo e nocivo, como imagens violentas ou pornográficas. Por exemplo, um criminoso pode usar a Nightshade para gerar imagens falsas de crianças sendo abusadas. Essas imagens falsas podem ser usadas para distribuir pornografia infantil ou para chantagear pessoas.

É importante usar a Nightshade de forma responsável e ética. A ferramenta não deve ser usada para criar desinformação, propaganda enganosa ou conteúdo ofensivo e nocivo.

Nightshade e a Ética na IA

A ascensão da Nightshade levanta questões importantes sobre a ética na formação de modelos de IA. Se, por um lado, a ferramenta pode proteger os artistas, por outro, pode ser usada de forma maliciosa para prejudicar ou enganar. É essencial que haja um equilíbrio entre a proteção dos direitos dos artistas e a prevenção do uso indevido de tais ferramentas.

Além disso, é crucial que as empresas de IA sejam transparentes sobre como treinam seus modelos e de onde vêm seus dados. A comunidade artística e o público em geral merecem saber como suas obras e informações são utilizadas, garantindo que a arte e a criatividade sejam respeitadas em uma era dominada pela inteligência artificial.

A Nightshade representa tanto os desafios quanto as oportunidades da interseção entre arte e IA. À medida que avançamos para o futuro, é imperativo que continuemos a refletir sobre as implicações éticas de nossas inovações e a buscar soluções que beneficiem a todos.

Eu sou o Denis Possi, apaixonado por inteligência artificial e fascinado pelas maravilhas da tecnologia. Sempre em busca de inovações, dedico-me a entender e compartilhar as transformações que a IA pode trazer para nossas vidas. Vem comigo e descubra o que o futuro nos reserva!